周跃峰:Token经济时代到来,需改进AI推理系统的效率和体验

8月12日,在上海举行的2025金融AI推理应用落地与发展论坛上,华为公司副总裁、数据存储产品线总裁周跃峰博士代表华为发布AI推理创新技术——UCM推理记忆数据管理器,以推动AI推理体验升级,提升推理性价比,加速AI商业正循环。

会上,基于华为携手中国银联率先在金融典型场景开展的UCM技术试点应用及成果,周跃峰博士发表了《AI推理科技创新,开启智慧金融新篇章》主题演讲。他指出,Token经济时代已经到来,AI真正创造价值的是推理过程,目前面临推不动、推得慢、推得贵三大挑战,需要改进推理系统的效率和体验。

以下是周跃峰博士演讲全文:

AI时代到来之后,训练是一个成本中心,真正给我们创造价值的是推理过程,但现在推理的效率以及推理体验是大家非常关注的一个问题。今天各个金融的AI场景创新过程中,对于Token的消耗越来越大,尤其在各个性能指标当中,以Token数——无论是首Token的时延,还是Token的流量,都是以Token数为量纲,我们有理由认为,AI的到来使得整个Token经济的时代也到来了。

今天我们实行AI行业化落地过程中,事实上我们也发现像刚才中国银联的杨总提到的,在推理过程中还是有不少挑战。(首先)可以看到,我们将一篇比较大的、长的文章放到推理系统当中时,有可能推理系统看了这一段忘了下面这一段,看了下面一段要前面一段给忘记了,因为推理窗口相对比较小,推不动。其次可以看到,由于在基础设施投资当中的差距,中国互联网的大模型首Token时延普遍慢于海外互联网头部的首Token时延。另外,每秒或者一定时间内推理的Token数也可以看到,我们在中国头部互联网中可以看到提供的服务也是远小于海外头部的互联网,这主要由于我们在AI基础设施投资方面,相对还是有差距。

因此,如何改进推理系统的效率和体验是我们重要的话题。这次我们和银联通过联合创新,推出了UCM推理记忆数据管理器。应该说,它对于过去我们试图用增加显存、内存来提升AI推理的效率和性能方面,是一个有效的突破。

大家知道,人也是一样,思考的能力跟记忆能力强相关——记忆能力既要记得东西多,而且还要记得快。这和我们思考能力是强相关的,AI推理系统也是一样的。整个AI推理系统当中,它的记忆往往有三部分:上面是高性能的缓存(HBM),中间是内存(DRAM),这两部分基本上在智算服务器当中;我们可以充分利用,但过去我们没有利用起来的是下面的专业的共享存储(SSD)。UCM推理记忆数据管理器通过一系列的算法,把我们在推理过程中不同的延时要求的数据放在不同的记忆体当中,对于实时的记忆数据即热的放在HBM当中,对于短期记忆数据相对比较热的放在存储当中,通过它极大提升系统的效率和AI推理的性能。

UCM主要分为三部分:(1)顶层跟业界流行的推理框架对接的这部分我们称作为“连接器”,它会连接业界普遍流行的推理引擎框架,包括华为的MindiE、SGLang等等,可以跟目前推理框架进行协同。(2)中间部分是加速程序,对于缓存记忆数据进行分级缓存管理的算法程序,运行在智算服务器当中。(3)另外一部分很重要的是跟专业的共享存储相结合的协同器,这个协同器(适配器)可以提升专业存储直通的效率和降低时延,可以让三级存储协同起来。

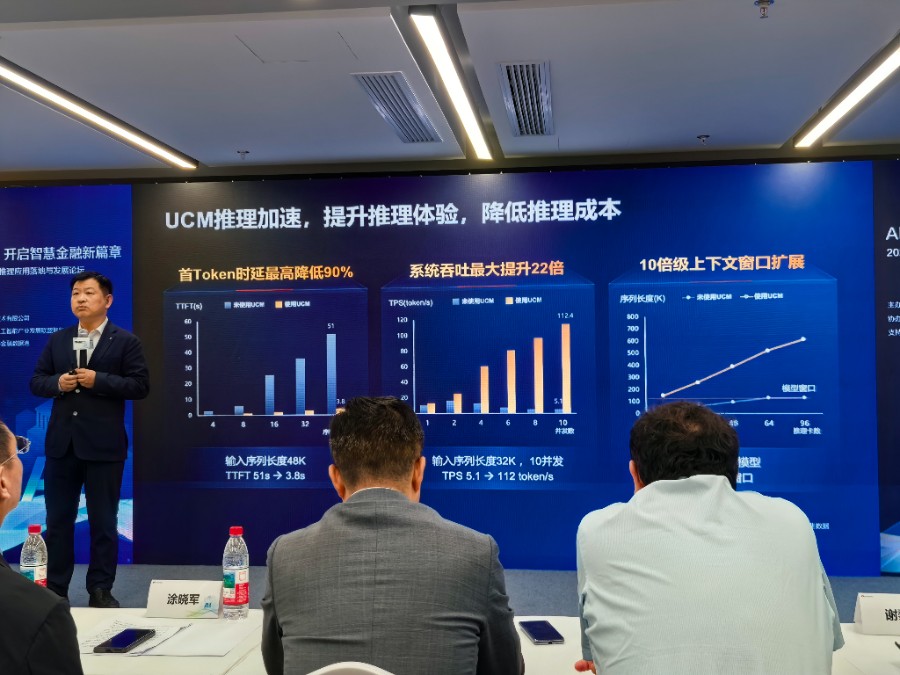

杨总在刚才的介绍当中得到了印证,我们通过大量测试确实也发现,通过这样的算法首Token时延最高可以降低90%,系统的吞吐率最大可以提升22倍,同时上下文推理的窗口也可以扩展10倍级以上,这对于提升推理系统的效能是一个非常大的进步。

这样的UCM推理记忆数据管理器,我们希望通过开放开源的方式,让业界都能够共享这个成果。感谢我们的联创团队,尤其是银联的工程师和华为的工程师。我们希望这个UCM和之前的ModelEngine已经开源的组件共同进行开源,9月份会在魔擎社区首发,当中很多算子,包括连接器这部分,也会在更多的开源社区,比如vLLM、华为的MindiE等等这些社区都会提贡献,让大家方便地在我们系统当中进行植入和用起来。

我们非常高兴地看到UCM在现在可以和银联一起,首先在我们金融智慧化的一些场景中应用起来,当然我们希望这个算法在双方的努力下,能够让更多的厂商使用,而且能够共享于更加高效的AI,让AI能够有更好的商业回报。