AIGC的下游应用与AI服务器的关键壁垒是什么?

应用:ChatGPT令人眼前一亮,下游应用如雨后春笋涌现

GPT基础能力包括文本生成(分析)、代码生成、对话交互、机器翻译、图像生成、视频生成等,借此赋能通用与垂直领域应用,有望带来商业模式的重塑与变革。

结合ChatGPT现有应用场景,以及对GPT未来模型演变的展望,我们归纳出GPT的基础能力,具体包括:文本生成(分析)、代码生成、对话交互、机器翻译、图像生成、视频生成等。

我们认为,这些基础能力将支撑GPT在通用与垂直领域的应用,新的应用领域出现也将基于这些能力的组合。例如,在办公软件领域,主要涉及GPT的文本能力;在教育行业,主要应用到文本、对话、翻译能力;在传媒行业,主要应用到图像、视频能力。

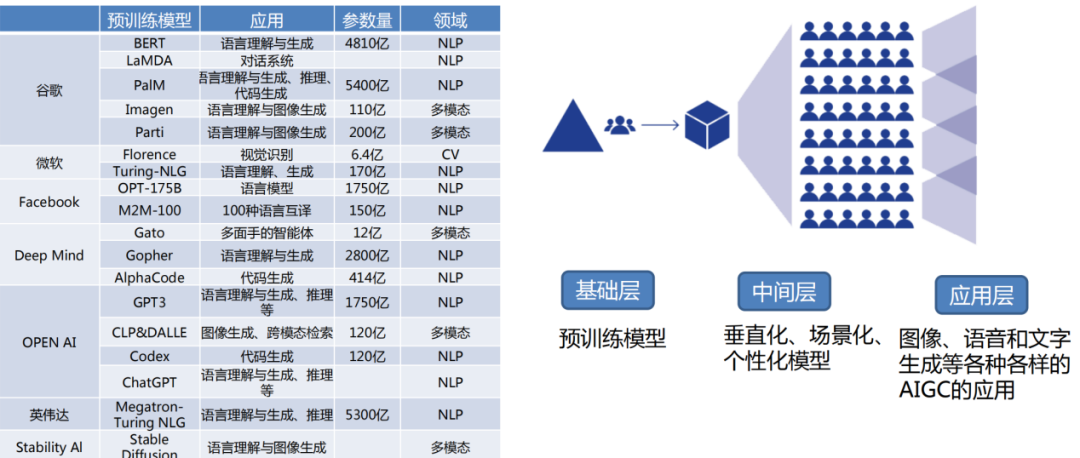

模型:头部厂商都不肯错过AGI的“iPhone”时刻,纷纷下场(海外)

AIGC国外主要预训练模型

模型:头部厂商都不肯错过AGI的“iPhone”时刻,纷纷下场(国内)

AIGC国内主要预训练模型

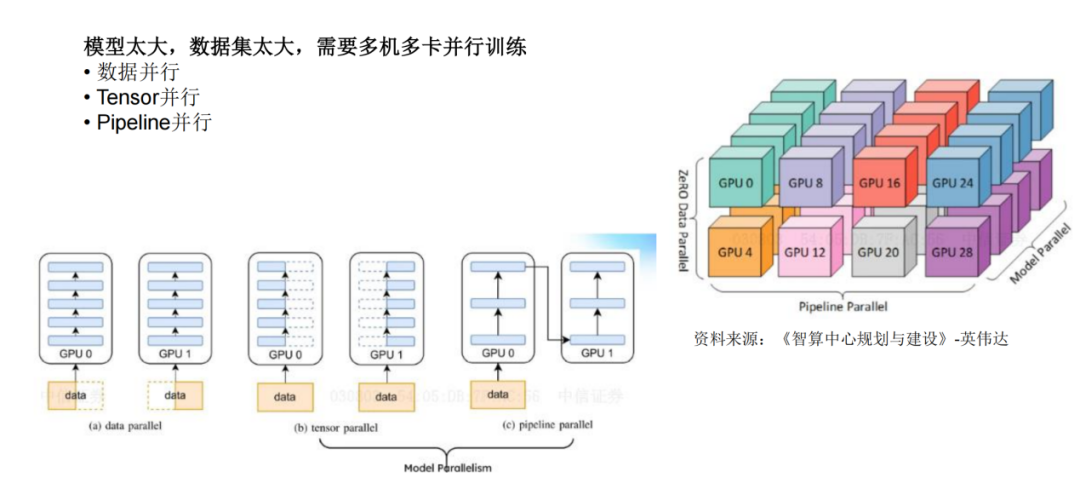

算力:大模型需要的算力与以往有什么不同

算力:训练和推理类ChatGPT大模型所需要的算力

(一)、训练一个GPT3.5类的AI模型需要的算力

➢训练所需资源与训练模型消耗的时间成反比,要求训练速度越短,消耗的资源量越大;

➢3个月内训练出一个版本的GPT3.5模型需要3000片A800 80G GPU,如果需要在1-2个月内训练出

GPT3大小的模型则需要10000+片A800 80G GPU;

➢微软已经向OpenAI公司投入数万片GPU;

(二)、推理

➢推理GPT3.5类的AI模型需要的算力

➢GPT3.5类AI模型属于大规模语言模型,由于模型过于巨大,无法放在1张A800 80G GPU上进行推理,

最少8卡A800 80G GPU进行推理保证延迟在1s以内;

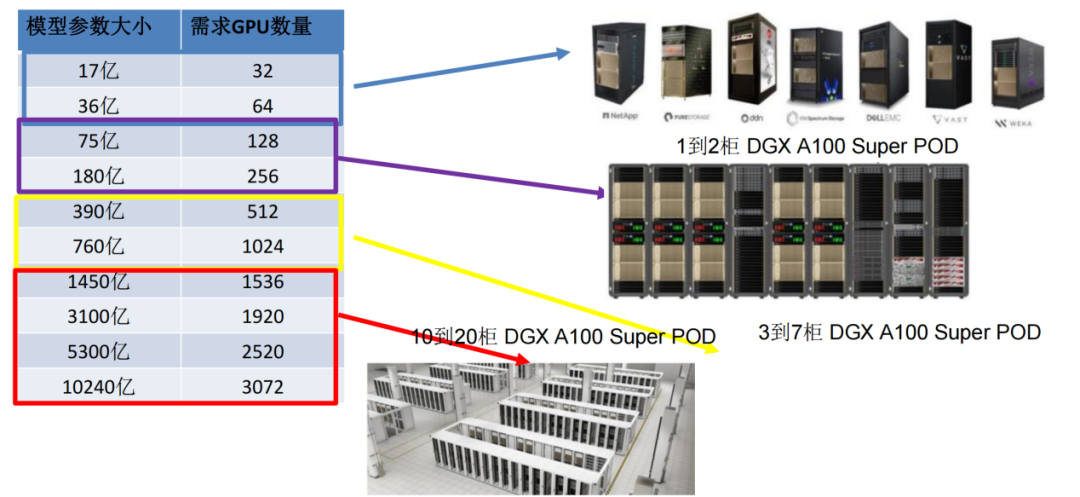

算力:不同规模的模型所需GPU数量

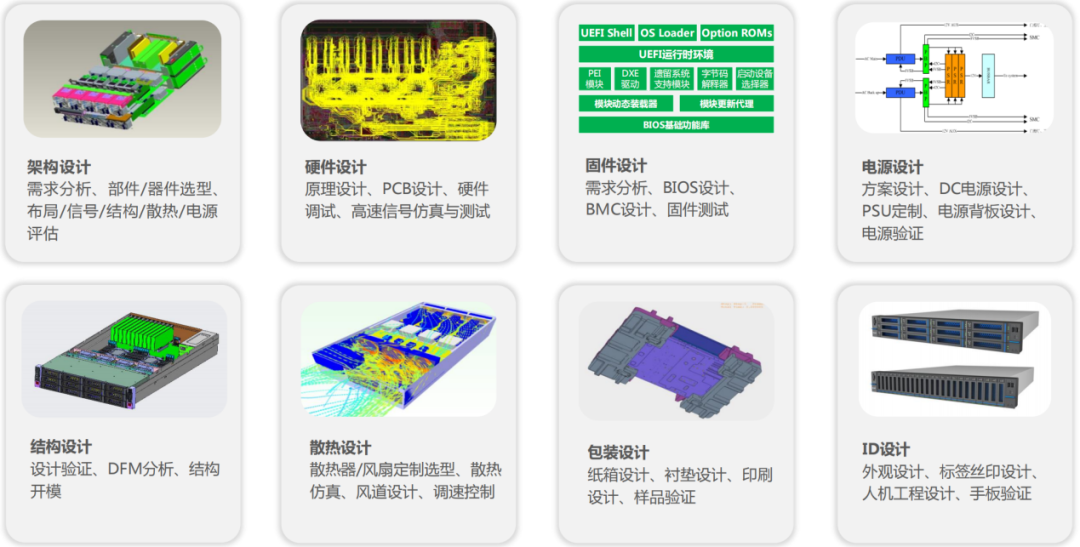

算力:AI服务器的关键壁垒是什么