GPU的未来展望

我们对数据中心的CPU计算引擎进行了50年的非常细粒度的分析,在CPU服务方面,变化以稳定但缓慢的速度发生。数据中心GPU计算引擎的兴起发生在短短的十五年之内,但据我们所知,还没有非常好的数据可以按数据中心的类型和价格范围来计算GPU计算。

部分原因是数据中心GPU计算引擎的绝大多数(过去四年超过95%)都来自一个非常神秘的供应商:Nvidia。虽然英伟达相当善于披露其众多设备的数据源和速度,但它并没有透露哪些设备以多少数量销售到数据中心。

还有一种误解,认为“Volta”V100、“Ampere”A100和“Hopper”H100等最高端产品推动了Nvidia大部分收入和最终用于服务器的GPU加速器的出货量。事实证明,这不是真的。我们不知道这有多少是不正确的,但我们开始尝试找出答案。

作为起点,我们向富国银行股票研究部董事总经理兼技术分析师Aaron Rakers寻求了一些帮助。出于对IT市场研究中常见分析机构(IDC、Gartner、Mercury Research等)提供的不完整GPU数据的同样的挫败感,Rakers进行了一些挖掘并构建了自己的模型,我们正在使用该模型(经许可))作为进一步预测数据中心Nvidia GPU市场将如何发展的基础,因为该公司转向每年发布一次GPU和CPU-GPU计算引擎公告,并且世界对GPU可能有着永不满足的胃口未来几年。

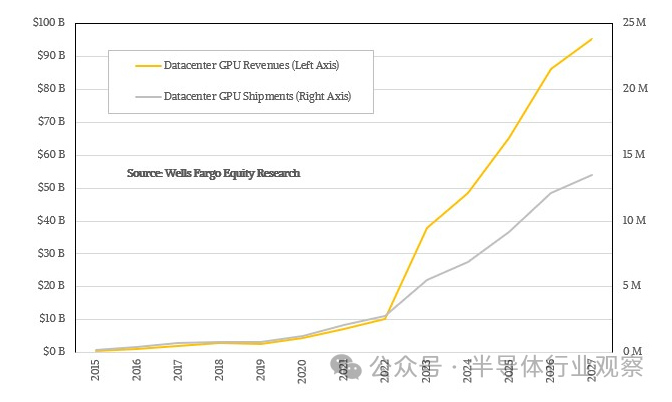

以下是Rakers对2015年至2022年全球GPU出货量和收入的估算,并从2023年到2027年进行了推断:

如您所见,2015年至2022年间,数据中心GPU销量与数据中心GPU出货量密切相关。AMD的出货量并不多,而英特尔在2015年至2017年间出货的是“Knights”Xeon Phi系列多核加速器。(严格来说,这些Xeon Phi设备是失败的GPU卡,后来变成了计算引擎。)

到2022年,生成式AI爆发式增长,数据中心GPU收入的增长速度开始远远快于受限的出货量。当需求过多而供应过少时就会发生这种情况。Rakers构建的模型假设这种供需之间的阻抗不匹配将持续到2027年,这就是为什么由Nvidia主导、AMD和英特尔在统计上有显着贡献的数据中心GPU销售额到2028年可能会超过1000亿美元如果目前的趋势持续下去。

顺便说一句,上述数据包括出售给数据中心用于任何用途的任何GPU,不仅是HPC和AI,还包括视频编码、元宇宙沉浸式模拟和虚拟现实以及各种其他类型的加速。这意味着它不仅包括依赖中介层技术、HBM堆叠内存和先进基板的设备,还包括使用GDDR内存、计算量显着减少且成本显着降低的低端设备。

Rakers认为Nvidia将继续在GPU领域占据主导地位,直到2027年,因为我们从Rakers整理的演示文稿中复制了这个怪物表,然后对其进行了一些分析:

在此表中,我们将任何作为独立PCI-Express卡、SXM模块或CPU-GPU混合封装出售的100系列Nvidia GPU称为单个GPU。我们认为,当制作GH200 Grace-Hopper超级芯片时,Grace CPU可能会使Hopper H100 GPU SXM5变体的成本增加10,000至15,000美元,而Hopper GPU SXM套件的定价在30,000美元到30,000美元之间。

据Rakers称,几周前,戴尔网站上的H100 SXM5设备标价为57,500美元。这不是英伟达从GPU上获得的钱,而是戴尔获得的钱。很难弄清楚Nvidia向OEM、ODM和直接客户收取Hopper GPU的费用,因为我们无法准确了解Nvidia数据中心部门或计算与网络部门体现的产品收入流。

我们对这些数据的主要研究是尝试找出Nvidia每年向数据中心运送多少GPU以及哪些类型,一般来说是使用CoWoS/HBM的GPU和不使用CoWoS/HBM的GPU,以及根据我们的预测,这种情况可能会发生怎样的变化未来,英伟达将拥有更广泛的产品线和更快的产品发布节奏。

和其他人一样,我们听说了Nvidia数据中心路线图,该路线图于2023年10月发布,隐藏在财务演示文稿中,您可能还记得,我们调整了该路线图以消除一些错误,并为过去提供了更准确的时间未来将推出200系列(CPU+SXM GPU)、100系列(SXM GPU)和40系列(GDDR和PCI-Express GPU),并添加“BlueField”DPU,仍以两年为周期。这是供您参考的路线图:

还有其他数据中心GPU(我们在2023年3月称之为人工智能革命的四大主力)仍在由Nvidia销售,包括“Ampere”A40、“Turing”T4、“Lovelace”L4以及Hopper当时在GTC 2023大会上宣布的H100NVL双宽单元。据我们所知,就单位出货量而言,这些非CoWoS/HBM设备在出货量中占主导地位,而CoWoS/HBM设备在整个Nvidia产品线的性能和收入中占主导地位。

但根据我们的估计,CoWoS/HBM设备在Nvidia GPU出货量中所占的份额将越来越大,从2022年至2027年(含)期间从四分之一左右上升到三分之一左右。这是我们的大胆猜测,如上表中的粗体红色斜体所示。

有两件事很难预测,但我们都想知道——我们是关注IT市场还是购买IT设备。第一个是每代GPU计算引擎的每一代将活跃销售多长时间,第二个是随着各代计算、内存和带宽容量的增加,这些产品将以什么价格出售?

我们假设一些事情。

首先,每个新的工艺节点和每个新的封装技术都会变得更加昂贵,而不是更便宜,因此我们相信所有产品系列的GPU设备都将变得更加昂贵,而不是更便宜。因此,我们预计,即使未来的“Blackwell”B100和未来代号未知且可能可变的X100进入该领域,Hopper H100s(H200只是H100的变体,具有更多HBM内存容量和带宽))仍将在现场。甚至可能到2027年,届时4纳米工艺和当前一代的CoWoS封装和HBM3内存将会成熟,并且可能比现在更便宜,因此,以相同的价格或更低的价格,Nvidia可以获得更多的利润。利润率。

我们认为Nvidia将拥有更广泛的产品线,其中包括寿命长的产品,这些产品随着时间的推移会变得更便宜,这就是为什么GPU的平均价格(正如Rakers所示)未来将保持不变。这就是我们要做的。就像与中档或低档CPU部件相比,顶级CPU部件的成本高于其相对性能一样,GPU也将采用相同的SKU定价。设备越先进、越紧凑、容量越大,您支付的费用就越多。

来自AMD、英特尔和其他公司的竞争不会改变这一点,因为他们没有任何动机发动价格战。这是一列非凡的肉汁列车,没有人会试图破坏它。

我们想知道价格范围是多少,但几十年来PC和服务器中确实有这样的先例。对于PC,从笔记本电脑到工作站级台式机,价格范围约为250美元、500美元、900美元、1,200美元、1,700美元、2,200美元和2,700美元。(我们粗略地说了分级。)对于配置的数据中心服务器,配置的X86计算机的分级顺序为2,500美元、5,000美元、8,000美元、10,000美元、20,000美元、40,000美元,依次类推。无论您谈论的是PC还是服务器,在这些价格范围内获得的计算、存储和网络方面的内容都会根据系统组件的路线图和经济性而变化。但OEM和ODM的目标不是改变价格,而是改变价格。这让我们养成了一个习惯:“我们的服务器低端机售价10,000美元,高端机售价20,000美元。”然后人们就不再那么关心金钱了。

CPU也已经进行了此类划分,并且给定频段所获得的结果会随着时间的推移而变化。

Nvidia V100上市时的价格约为10,000美元,A100也是如此,但H100的价格达到了30,000美元,并从此上涨。由于供不应求,所有GPU价格都随之上涨。我们不会感到惊讶的是,CoWoS/HBM GPU可能会在2024年进入10,000美元、20,000美元和30,000美元级别,而未来的40,000美元和50,000美元级别将在未来几代中出现。

用于推理、元宇宙和其他工作负载的低端设备的出货量将大得多,价格范围从1,500美元起,可能会升至2,500美元,然后是5,000美元,然后是10,000美元,最后是20,000美元。(几周前,戴尔网站上有一台L40S,售价为20,000美元。)

这意味着,在未来的某个时候,可能会出现一个价值100万美元的人工智能服务器节点,配备16个GPU,并满载互连、内存和计算。